viernes, 11 de diciembre de 2009

Visual FoxPro

Características [editar]

Visual FoxPro ofrece a los desarrolladores un conjunto de herramientas para crear aplicaciones de bases de datos para el escritorio, entornos cliente/servidor, tablet PC o para la Web.

Entre sus características se pueden enumerar:

Capacidades poderosas y muy veloces para el manejo de datos nativos y remotos.

Flexibilidad para crear todo tipo de soluciones de bases de datos.

Lenguaje de Programación Orientado a objetos.

Utilización de Sentencias SQL en forma nativa.

Poderoso manejo de vistas y cursores y control completo de estructuras relacionales.

Su propio gestor de base de datos incorporado. Sin embargo, también puede conectarse con servidores de base de datos, tales como Oracle, Microsoft SQL Server o MySQL.

Cuenta con un motor de generación de informes renovado y muy flexible para soluciones más robustas.

Desde la versión 9.0, amplio soporte de XML, tanto como fuente de datos (por ej., servicios Web basados en XML) como por generar reports en formato XML.

Desde la versión 7.0, soporte de la tecnología IntelliSense de Microsoft

La última versión liberada es la 9.0.

Se planeo inicialmente la salida de una nueva versión llamada 'Sedna', la cual pretendía ser un poderoso y completo lenguaje interactuando aun más con VisualStudio.net, SQLServer2005, SQLExpress2005 y Office12 teniendo a su vez soporte para Windows Vista. Posteriormente se supo que no habrá una próxima versión (Mensaje a la comunidad VFP). Microsoft ha cancelado su desarrollo y lanzó lo que han hecho hasta ahora como add-ons en conjunto con el service pack 2 ambos por el momento en versión Beta (SP2 y "Sedna" - Beta). Igualmente, según las políticas de soporte de Microsoft, éste continuara dando soporte al producto hasta el año 2015.

Hay un movimiento MasFoxPro que está haciendo presión para que Microsoft continúe, o deje el Visual FoxPro como código abierto para que otra gente pueda seguir evolucionándolo.

La versión 9.0 de Visual FoxPro cuenta con el SP1 y el (más reciente) SP2 (en inglés) en los que hay algunas nuevas características y especialmente brindan estabilidad al producto.

Historia [editar]

Visual FoxPro proviene de FoxPro, que a su vez deriva de FoxBASE, creado por Fox Technologies en 1984; inicialmente un compilador de dBase, acabó superándolo y con Clipper, convirtiéndose en una de las estrellas de los lenguajes xBase. Fox Technologies fue adquirido por Microsoft en 1992.

Visual FoxPro 3.0, fue la primera versión “Visual”, redujo su compatibilidad a solo Mac y Windows (La última versión de FoxPro (2.6) corría en MS-DOS, MS Windows, Mac OS y UNIX), versiones posteriores fueron solo para Windows. La versión actual se basa en archivos COM y Microsoft ha declarado que no piensan crear una versión .NET.

En la versión 5.0 se integra en Microsoft Visual Studio añadiendosele el soporte de Microsoft Source Safe. Hasta entonces es visto tipicamente por el público como meramente un Sistema de gestión de base de datos (SGBD), ignorando el hecho de que no solo incluye el entorno SGBD, sino un completo lenguaje de programación.

Visual FoxPro 6.0, publicado en 1999, no supone un cambio radical respecto de la anterior versión sino únicamente una mejora en sus diversas funcionalidades y una adaptación al mundo internet y al mundo de los objetos. Esta versión hace más atractivo a los desarrolladores el tratamiento de los datos en los entornos COM. Es un paso más en la evolución de este producto desde un entorno de aplicaciones monousuario o de redes pequeñas centradas en los datos hacia una herramienta orientada a objeto diseñada para la construcción de la lógica del negocio en los entornos multi-tier con una fuerte orientación hacia los tratamientos intensivos de datos en Internet. Pese a su relativa antigüedad, es hoy todavía ámpliamente utilizado en grandes empresas (por ej., la compañía de seguros Mapfre) por su estabilidad.

Visual FoxPro 7.0, publicado en 2001, supuso su salida de Visual Studio, pues aunque en un principio se pensaba incluir a Fox en .NET, no era posible sin romper con la herencia de anteriores versiones. Esta versión incorporó por primera vez el IntelliSense, y se mejoró el manejo de arrays, acercándolo al de cursores.

A finales del 2002, algunos miembros de comunidades demostraron que Visual FoxPro puede correr en Linux usando un reimplememtador del API de Windows (Win16 y Win32) llamado Wine. En el 2003, esto llevo a quejas de Microsoft: se dijo que el desarrollo de código de FoxPro para rutinas en máquinas no-Windows viola el Acuerdo de Licencia de Usuario Final.

Los rumores de que Microsoft planea terminar el soporte para FoxPro han sido comunes desde su adquisición del producto, a pesar del hecho de que éste ha tenido el tiempo de vida de soporte más largo para un producto de Microsoft (hasta el 2014). VFP 9 fue lanzado el 17 de diciembre del 2004 y el equipo de Fox luego trabajó en un proyecto cuyo nombre clave fue Sedna. Este fue construido sobre el código base de VFP 9 y consistió principalmente en componentes Xbase que soportando un número de escenarios interoperables con varias tecnologías de Microsoft incluyendo SQL Server 2005, .NET, WinFX, Windows Vista y Office 12. Lamentablemente el proyecto no prosperó y fue cancelado por Microsoft.

Visual Foxpro no va a desaparecer ya que una empresa llamada etecnologia "www.etecnologia.net" ha desarrollado el .NET EXTENDER que permite utilizar el .net framework en visual foxpro, y han anunciado que a finales del 2009 van a sacar su "VFP Developer Studio" herramienta la cual convierte a VFP en un lenguaje .Net. este producto esta soportando el 92 por ciento de los comandos y funciones de VFP al 31 de mayo del 2009 y se puede comprar por $250.00.

No obstante, siempre parece el patito feo de los productos Microsoft. Solicitar información sobre él en cualquier stand oficial de una feria informática como el español SIMO supone que se deba preguntar al menos a 3 personas, y muchas veces el usuario de Fox dispone de mayor información que los empleados (azafatas) presentes en él. Son varios los testimonios de visitas a empresas por parte de delegaciones de la central de Microsoft que no han sabido reconocer el producto como propio o lo han confundido con Visual Basic.

En la actualidad, a pesar que Microsoft ha decicido no continuar con Microsoft Visual FoxPro, la gran comunidad que poseen los desarrolladores de Fox son muchísimos en todo el mundo, sin duda es una de las comunidades mas importantes en el mundo de la programación e incluso lograron traducir al español la version 8.0. Comunidades como PortalFox y Mundo Visual FoxPro son las mas importantes entre los desarrolladores de habla hispana.

La gran mayoría de programadores Visual FoxPro se resisten a dejar de programar en este lenguaje porque consideran que es una herramienta muy poderosa, versátil y robusta que les permite crear aplicaciones tan poderosas y hasta más estables que las creadas por otros lenguajes. Incluso programadores que han tenido la oportunidad de desarrollar tanto en Visual Basic.NET y Visual FoxPro 9.0 coinciden que FoxPro es largamente superior en cuanto a practicidad y flexibilidad al momento de programar. Algunos miembros de la comunidad acusaron a Microsoft de "matar" a Visual FoxPro por el simple hecho que era más poderoso que su producto "el engreído Visual Basic".

excel y la estadistica

· En la actualidad se está reconociendo la importancia de la probabilidad y la estadística dentro de los programas educativos, como una asignatura que fortalece la toma de decisiones.

· A nivel universitario los cursos de estadística se incluyen prácticamente en todas las especialidades, ya sea como probabilidad y estadística, bioestadística, teoría del muestreo o con algún otro nombre, hoy en día la estadística se encuentra presente en los diferentes campos de la ciencia.

· Para empezar a trabajar en la estadística no se necesita un dominio profundo de la matemática, basta con la comprensión de los propios conceptos estadísticos.

· La preparación estadística actual incluye la habilidad de procesamiento de datos a través de un programa estadístico.

Esta realidad nos obliga, de acuerdo a nuestros recursos, a acercar a los estudiantes a programas de análisis estadístico, considerando que el rápido desarrollo de la estadística y su difusión en la época moderna se ha debido a la presencia de la computadora facilitando la acelerada cuantificación de nuestra sociedad y al modo en que los datos son recogidos y procesados.[5]

También debemos considerar que como materia del área de las matemáticas, la computadora no es sólo un recurso de cálculo, sino también un recurso didáctico potente y muy útil, que nos permite conseguir una aproximación más exploratoria y significativa en la enseñanza de la estadística[6]. Por sí misma la computadora nos permite lograr ciertos avances en el aprendizaje pues evita: la realización de cálculos tediosos, y pocos constructivos; las largas jornadas desgastantes en la introducción de enormes conjuntos de datos; y facilita la actualidad y posible adecuación de las prácticas a los intereses personales de los estudiantes cuando se conjuga con Internet. Brindando por todo ello, un efecto por demás motivador en el estudiante (Hernando 2003).

Hasta hace algunos años, el análisis de datos estaba reservado a profesionales, quienes tenían que diseñar sus propios programas para realizar los cálculos, poco podíamos esperar de la experiencia educativa. Sin embargo en los últimos veinte años , el campo de la estadística se ha transformado radicalmente gracias al desarrollo de programas de computadora especialmente diseñados para el análisis estadístico.”Durante los ochenta, el software estadístico experimentó una vasta revolución tecnológica. Además de las mejoras manifestadas en actualizaciones periódicas, la disponibilidad de computadoras personales condujo al desarrollo de nuevos paquetes que usaban una interfaz manejada por menús”[7]

Esta revolución tecnológica trajo consigo una gran variedad de programas estadísticos, tanto de tipo profesional, como los desarrollados con fines educativos. Paquetes estadísticos profesionales como SAS, SPSS, SYSTAT, STATISTICS, etc. aparecieron en el mercado informático.

También tenemos los desarrollados especialmente para ser usados en la enseñanza, como MINITAB. Toda esta paquetería representó al final de la década de los ochenta y el principio de los noventa la realidad de un período continuo de avances tecnológicos manifestados en procedimientos estadísticos adicionales cada vez más sofisticados.

Es evidente que el uso de los paquetes de software es algo común dentro de los ambientes empresariales, de investigación y académicos. Así, tenemos entornos operativos "amistosos" , que permiten acceder directamente al manejo de cualquiera de los módulos de un paquete estadístico y, con la ayuda del "ratón", explorar sus posibilidades.

Por otro lado, existen programas "de consulta" (Brent y Mirelli, 1991) a los cuales se puede recurrir para obtener un "consejo" sobre el método de análisis que se debe aplicar en función del tipo de datos y las hipótesis sobre los mismos.

Sin embargo, tenemos que reconocer que pese a la variedad de software existentes en el medio, la realidad de la educación en nuestros países, en nuestras universidades supera muchas veces las expectativas de los programas; la situación económica por la que atraviesan la mayoría de las instituciones nos obliga a buscar alternativas económicas y asequibles a nuestros estudiantes, que permitan llevar los conceptos estadísticos y su metodología a la práctica a través de aplicaciones informáticas, logrando con ello manipular formulas y variables de acuerdo a un problema determinado.

Por otro lado, en años de experiencia con alumnos del área administrativa, cuyos conocimientos de matemáticas no son profundos, hemos detectado que para poder trabajar en estadística con estudiantes aún “inexpertos” en programas estadísticos necesitamos que el software utilizado cumpla determinadas condiciones:

· Un proceso de instalación automático y sencillo.

· Introducción sencilla de la información.

· Definición de variables y creación de ficheros de forma intuitiva.

· Importación y exportación de datos desde los formatos más habituales

· Operadores (aritméticos, lógicos y relacionales).

· Funciones

La hoja de cálculo de Excel, ha cumplido perfectamente con estas condiciones y si tomamos en cuenta que por formar parte del paquete integrado Microsoft Office (en cualquiera de sus versiones) se encuentra prácticamente a la mano de cualquier estudiante, lo que le ha permitido permanecer por su sencillez, disponibilidad y relación calidad/precio como una herramienta idónea tanto para estudiantes, usuarios principiantes como para maestros usuarios avanzados, que deseen realizar una análisis estadístico.

Excel, dependiendo de la versión, es un programa que se ajusta bastante bien al contenido mínimo de muchos de los programas educativos y que cumple con las condiciones señaladas anteriormente (en el caso de Excel 1997 y Excel 2000 carecen de algunas funciones ya actualizadas en el XP). Se trata de un software considerado actualmente como estándar en todos los entornos (educativo, profesional, familiar, etc), que posee la virtud de presentar una interfaz agradable y una facilidad de uso digna de elogio[8].

Cabe señalar algunas de las ventajas que hemos identificado en la práctica, al trabajar procedimientos estadísticos, inclusos aquellos considerados como difíciles.

· Las funciones utilizan una sintaxis común de acuerdo al nombre de estas, olvidándose de aquella típica de programación.

· Al utilizar funciones de aplicación inmediata optimizan la funcionalidad.

· Al aplicar las funciones se realiza la retrolimentación de conceptos a través de sus cuadros de diálogos.

· El programa integrado de Office por sí mismo ofrece una gran ayuda.

· Tiene una capacidad gráfica muy variada que permite trabajar en cualquiera de las etapas de una análisis estadístico.

· Tiene la posibilidad de automatizar cualquier tarea repetitiva a través del uso de macros de fácil aplicación.

También tenemos que considerar que la instalación del programa mismo es muy sencillo, requiriendo características mínimas muy básicas que se encuentran prácticamente disponibles en cualquier computadora actualmente, y por si fuera poco, el programa no ocupa mucho espacio en el disco duro y por ende no necesita demasiada memoria para funcionar.

Como una bondad adicional, Microsoft Excel incluye un comando para el análisis de datos, dentro de las “herramientas para análisis”, que se pueden utilizar para análisis estadísticos más complejos y avanzados. Su uso es poco común, pues la mayoría de las ocasiones al instalarse Excel no se tiene el cuidado de instalar todas las funciones dentro de las “herramientas” en forma completa y con ello la opción de “Análisis de datos” , perdiendo la oportunidad de utilizar un medio muy poderoso para el análisis dentro de la estadística.

Por último debemos mencionar que ante el uso de un programa informático para el análisis estadístico, el que sea, debemos de realizar algunas consideraciones más allá del uso de herramienta propia en la educación.

Si bien, la computadora y los softwares estadísticos pueden y deben incluirse dentro de los programas de estadística como un instrumento de cálculo y representación gráfica, para analizar tanto los datos colectados por el estudiante mismo como aquellos proporcionados por el profesor; debemos preparar a los alumnos para recolectar, organizar, editar, almacenar, representar y analizar sistemas de datos con la computadora, cuya complejidad sea adecuada a su realidad.

Los objetivos del uso de la computadora comienzan por la comprensión de conceptos afines, empezando desde los básicos, como variables y conjunto de datos; no debemos olvidar el impacto que causa en los alumnos el empleo de sistemas de datos reales y significativos a su entorno: sus calificaciones escolares, los resultados de sus equipos deportivos favoritos, los noviazgos juveniles experimentados[9], etc.

Si la información analizada tiene significado y si para ellos es fiable, habrá mucho mayor disposición al momento de llevar el sistema de datos a la computadora y poder realizar sus análisis, eliminando un problema tradicional en la enseñanza de la estadística, el desfase entre la comprensión de los conceptos y los medios técnicos de cálculo para poder aplicarlos. [10]

También debemos considerar que la actual facilidad de empleo de procedimientos estadísticos, implica, el riesgo del uso no adecuado de estos. Es muy común que tras la recolección de un conjunto de datos se piense que es suficiente aplicar un programa estadístico para tener el análisis, pensando erróneamente que este automáticamente realizará la interpretación de los resultados obtenidos.

Debemos habilitar a los alumnos para planificar el análisis que desean desarrollar incluso antes de finalizar el diseño de su conjunto de datos, considerando que la culminación de este dependerá de ellos al momento de trasladar el valor numérico obtenido a la realidad de la cual fue extraído originalmente De otro modo, sus conclusiones pudieran carecer de valor y de riqueza explicativa.

Conclusiones

A través de este documento sea han analizado algunos de los objetivos educativos que la disponibilidad de las computadoras y paquetes informáticos, plantea sobre la enseñanza de la estadística, reconociendo que:

· Las TIC’s ofrecen nuevas y poderosas herramientas de participación y toma de partido en forma deliberada en los procesos educativos.

· El uso de la computadora ayuda a sostener el interés del estudiante para desarrollar tareas que son tediosas si se llevan a cabo de la manera tradicional, con lápiz y papel.

· También se han señalado las posibilidades didácticas de la computadora en el análisis estadístico.

· Se han evidenciado las “bondades” del uso de la hoja de cálculo de Excel como un "software" didáctico asequible en la enseñanza de la estadística.

· No existen programas que por sí mismos resuelvan el problema de la enseñanza de la estadística . Es necesario un estudio concienzudo y profundo que permite el empleo de cualquier software estadístico en los programas educativos de estadístic a.

SPSS

Tipo: Se utiliza para modificar el tipo de la variable y el formato. Cuando se pincha en Tipo... dentro de Cambiar parámetros, aparece la siguiente ventana:

jueves, 10 de diciembre de 2009

trabajo practico de info 111

SAS, o Statistical Analysis System, fue diseñado como una herramienta de analisis de datos para todo propósito. SAS proporciona herramientas para el almacenamiento y recuperación de información, modificacion de datos y programación; elaboración de reportes, estadística simple y avanzada, y el manejo de archivos. Varos de los productos de SAS son integrados con el SAS BASE para proporcional un sistema completo. Por ejemplo, el modulo SAS/STAT provee una poderosa herramienta para procedimientos de análisis estadístico el cual incluye regresión, analisis de varianza, análisis de datos categórico, análisis multivariado, análisis discriminante, análisis de conglomerados, etc. El modulo SAS/ETS provee procedimientos para realizar análisis de Series de Tiempo y el SAS/IML es usado pra la manipulación de datos matriciales.

Manual en linea: http://support.sas.com/documentation/onlinedoc/91pdf/index_913.html

Guía de instalación:http://ca.huji.ac.il/services/software/guides/sas9.1.3.shtml

Info de la descarga:

IMAGENES: ISO

TAMAÑO: 19 X 98MB + 1 X 86MB

PASS: 4all_by_wolverine

http://rapidshare.com/files/13208620/statsas_by_wolverine.part01.rar

http://rapidshare.com/files/13304304/statsas_by_wolverine.part02.rar

http://rapidshare.com/files/13228576/statsas_by_wolverine.part03.rar

http://rapidshare.com/files/13233537/statsas_by_wolverine.part04.rar

http://rapidshare.com/files/13237125/statsas_by_wolverine.part05.rar

http://rapidshare.com/files/13240680/statsas_by_wolverine.part06.rar

http://rapidshare.com/files/13243945/statsas_by_wolverine.part07.rar

http://rapidshare.com/files/13246989/statsas_by_wolverine.part08.rar

http://rapidshare.com/files/13249668/statsas_by_wolverine.part09.rar

http://rapidshare.com/files/13252172/statsas_by_wolverine.part10.rar

http://rapidshare.com/files/13254623/statsas_by_wolverine.part11.rar

http://rapidshare.com/files/13256800/statsas_by_wolverine.part12.rar

http://rapidshare.com/files/13258972/statsas_by_wolverine.part13.rar

http://rapidshare.com/files/13260916/statsas_by_wolverine.part14.rar

http://rapidshare.com/files/13262601/statsas_by_wolverine.part15.rar

http://rapidshare.com/files/13264102/statsas_by_wolverine.part16.rar

http://rapidshare.com/files/13265827/statsas_by_wolverine.part17.rar

http://rapidshare.com/files/13267305/statsas_by_wolverine.part18.rar

http://rapidshare.com/files/13269200/statsas_by_wolverine.part19.rar

http://rapidshare.com/files/13270475/statsas_by_wolverine.part20.rar

lunes, 7 de diciembre de 2009

estadistica!!!!

La estadística es una ciencia con base matemática referente a la recolección, análisis e interpretación de datos, que busca explicar condiciones regulares en fenómenos de tipo aleatorio.

Es transversal a una amplia variedad de disciplinas, desde la física hasta las ciencias sociales, desde las ciencias de la salud hasta el control de calidad. Se usa para la toma de decisiones en áreas de negocios o instituciones gubernamentales.

La estadística se divide en dos ramas:

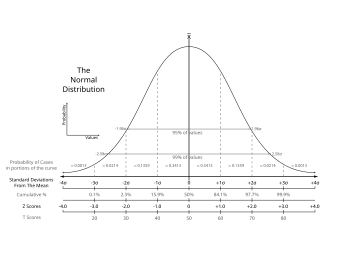

- La estadística descriptiva, que se dedica a los métodos de recolección, descripción, visualización y resumen de datos originados a partir de los fenómenos en estudio. Los datos pueden ser resumidos numérica o gráficamente. Ejemplos básicos de parámetros estadísticos son: la media y la desviación estándar. Algunos ejemplos gráficos son: histograma, pirámide poblacional, clústers, etc.

- La inferencia estadística, que se dedica a la generación de los modelos, inferencias y predicciones asociadas a los fenómenos en cuestión teniendo en cuenta la aleatoriedad de las observaciones. Se usa para modelar patrones en los datos y extraer inferencias acerca de la población bajo estudio. Estas inferencias pueden tomar la forma de respuestas a preguntas si/no (prueba de hipótesis), estimaciones de características numéricas (estimación), pronósticos de futuras observaciones, descripciones de asociación (correlación) o modelamiento de relaciones entre variables (análisis de regresión). Otras técnicas de modelamiento incluyen anova, series de tiempo y minería de datos.

Ambas ramas (descriptiva e inferencial) comprenden la estadística aplicada. Hay también una disciplina llamada estadística matemática, la cual se refiere a las bases teóricas de la materia. La palabra «estadísticas» también se refiere al resultado de aplicar un algoritmo estadístico a un conjunto de datos, como en estadísticas económicas, estadísticas criminales, etc.

Etimología

La palabra «estadística» procede del latín statísticum collégium (‘consejo de Estado’) y de su derivado italiano statista (‘hombre de Estado’ o ‘político’). El término alemán statistik, que fue primeramente introducido por Gottfried Achenwall (1749), designaba originalmente el análisis de datos del Estado, es decir, «la ciencia del Estado» (también llamada «aritmética política» de su traducción directa del inglés). No fue hasta el siglo XIX cuando el término «estadística» adquirió el significado de recolectar y clasificar datos. Este concepto fue introducido por el inglés John Sinclair.

En su origen, por tanto, la estadística estuvo asociada a datos, a ser utilizados por el gobierno y cuerpos administrativos (a menudo centralizados). La colección de datos acerca de estados y localidades continúa ampliamente a través de los servicios de estadística nacionales e internacionales. En particular, los censos suministran información regular acerca de la población.

Desde los comienzos de la civilización han existido maneras sencillas de estadística, pues ya se utilizaban representaciones gráficas y otros símbolos en pieles, rocas, palos de madera y paredes de cuevas para contar el número de personas, animales o ciertas cosas. Hacia el año 3000 a. C.Números y Crónicas incluyen, en algunas partes, trabajos de estadística. El primero contiene dos censos de la población de Israel y el segundo describe el bienestar material de las diversas tribus judías. En China existían registros numéricos similares con anterioridad al año 2000 a. C. Los griegos clásicos realizaban censos cuya información se utilizaba hacia el 594 a. C. para cobrar impuestos. los babilónicos usaban ya pequeñas tablillas de arcilla para recopilar datos en tablas sobre la producción agrícola y de los géneros vendidos o cambiados mediante trueque. Los egipcios analizaban los datos de la población y la renta del país mucho antes de construir las pirámides en el siglo XI a. C. Los libros bíblicos de

Orígenes en probabilidad

Los métodos estadístico-matemáticos emergieron desde la teoría de probabilidad, la cual data desde la correspondencia entre Blaise Pascal y Pierre de Fermat (1654). Christian HuygensArs coniectandiJakob Bernoulli y la Doctrina de posibilidades (1718) de Abraham de Moivre[1] En la era moderna, el trabajo de Kolmogórov ha sido un pilar en la formulación del modelo fundamental de la Teoría de Probabilidades, el cual es usado a través de la estadística. (1657) da el primer tratamiento científico que se conoce a la materia. El (póstumo, 1713) de estudiaron la materia como una rama de las matemáticas.

La teoría de errores se puede remontar a la Ópera miscellánea (póstuma, 1722) de Roger CotesThomas Simpson en 1755 (impreso en 1756) el cual aplica por primera vez la teoría de la discusión de errores de observación. La reimpresión (1757) de este trabajo incluye el axioma de que errores positivos y negativos son igualmente probables y que hay unos ciertos límites asignables dentro de los cuales se encuentran todos los errores; se describen errores continuos y una curva de probabilidad. y al trabajo preparado por

Pierre-Simon Laplace (1774) hace el primer intento de deducir una regla para la combinación de observaciones desde los principios de la teoría de probabilidades. Laplace representó la ley de probabilidades de errores mediante una curva y dedujo una fórmula para la media de tres observaciones. También, en 1871, obtiene la fórmula para la ley de facilidad del error (término introducido por Lagrange, 1744) pero con ecuaciones inmanejables. Daniel Bernoulli (1778) introduce el principio del máximo producto de las probabilidades de un sistema de errores concurrentes.

El método de mínimos cuadrados, el cual fue usado para minimizar los errores en mediciones, fue publicado independientemente por Adrien-Marie Legendre (1805), Robert Adrain (1808), y Carl Friedrich Gauss (1809). Gauss había usado el método en su famosa predicción de la localización del planeta enano Ceres en 1801. Pruebas adicionales fueron escritas por Laplace (1810, 1812), Gauss (1823), James Ivory (1825, 1826), Hagen (1837), Friedrich Bessel (1838), W.F. DonkinJohn Herschel (1850) y Morgan Crofton (1870). Otros contribuidores fueron Ellis (1844), Augustus De Morgan (1864), Glaisher (1872) y Giovanni Schiaparelli (1875). La fórmula de Peters para (1844, 1856), r, el probable error de una observación simple es bien conocido.

El siglo XIX incluye autores como Laplace, Silvestre Lacroix (1816), Littrow (1833), Richard Dedekind (1860), Helmert (1872), Hermann Laurent (1873), Liagre, Didion y Karl Pearson. Augustus De Morgan y George Boole mejoraron la presentación de la teoría. Adolphe Quetelet(l’homme moyen) como un medio de entender los fenómenos sociales complejos tales como tasas de criminalidad, tasas de matrimonio o tasas de suicidios. (1796-1874), fue otro importante fundador de la estadística y quien introdujo la noción del «hombre promedio»

Estado actual

Durante el siglo XX, la creación de instrumentos precisos para asuntos de salud públicaepidemiología, bioestadística, etc.) y propósitos económicos y sociales (tasa de desempleo, econometría, etc.) necesitó de avances sustanciales en las prácticas estadísticas. (

Hoy el uso de la estadística se ha extendido más allá de sus orígenes como un servicio al Estadouniversidades tienen departamentos académicos de matemáticas y estadística separadamente. La estadística se enseña en departamentos tan diversos como psicología, educación y salud pública. o al gobierno. Personas y organizaciones usan la estadística para entender datos y tomar decisiones en ciencias naturales y sociales, medicina, negocios y otras áreas. La estadística es entendida generalmente no como un sub-área de las matemáticas sino como una ciencia diferente «aliada». Muchas

Al aplicar la estadística a un problema científico, industrial o social, se comienza con un proceso o población a ser estudiado. Esta puede ser la población de un país, de granos cristalizados en una roca o de bienes manufacturados por una fábrica en particular durante un periodo dado. También podría ser un proceso observado en varios instantes y los datos recogidos de esta manera constituyen una serie de tiempo.

Por razones prácticas, en lugar de compilar datos de una población entera, usualmente se estudia un subconjunto seleccionado de la población, llamado muestra. Datos acerca de la muestra son recogidos de manera observacional o experimental. Los datos son entonces analizados estadísticamente lo cual sigue dos propósitos: descripción e inferencia.

El concepto de correlación es particularmente valioso. Análisis estadísticos de un conjunto de datos puede revelar que dos variables (esto es, dos propiedades de la población bajo consideración) tienden a variar conjuntamente, como si hubiera una conexión entre ellas. Por ejemplo un estudio del ingreso anual y la edad de muerte entre personas podría resultar en que personas pobres tienden a tener vidas más cortas que personas de mayor ingreso. Las dos variables se dicen a ser correlacionadas. Sin embargo, no se pude inferir inmediatamente la existencia de una relación de causalidad entre las dos variables. El fenómeno correlacionado podría ser la causa de un tercero, previamente no considerado, llamado variable confundida.

Si la muestra es representativa de la población, inferencias y conclusiones hechas en la muestra pueden ser extendidas a la población completa. Un problema mayor es el de determinar que tan representativa es la muestra extraída. La estadística ofrece medidas para estimar y corregir por aleatoriedad en la muestra y en el proceso de recolección de los datos, así como métodos para diseñar experimentos robustos como primera medida, ver diseño experimental.

El concepto matemático fundamental empleado para entender la aleatoriedad es el de probabilidad. La estadística matemática (también llamada teoría estadística) es la rama de las matemáticas aplicadas que usa la teoría de probabilidades y el análisis matemático para examinar las bases teóricas de la estadística.

El uso de cualquier método estadístico es válido solo cuando el sistema o población bajo consideración satisface los supuestos matemáticos del método. El mal uso de la estadística puede producir serios errores en la descripción e interpretación, afectando las políticas sociales, la práctica médica y la calidad de estructuras tales como puentes y plantas de reacción nuclear.

Incluso cuando la estadística es correctamente aplicada, los resultados pueden ser difícilmente interpretados por un no experto. Por ejemplo, el significado estadístico de una tendencia en los datos, que mide el grado al cual la tendencia puede ser causada por una variación aleatoria en la muestra, puede no estar de acuerdo con el sentido intuitivo. El conjunto de habilidades estadísticas básicas (y el escepticismo) que una persona necesita para manejar información en el día a día se refiere como «cultura estadística».

Métodos estadísticos

Estudios experimentales y observacionales

Un objetivo común para un proyecto de investigación estadística es investigar la causalidad, y en particular extraer una conclusión en el efecto que algunos cambios en los valores de predictores o variables independientes tienen sobre una respuesta o variables dependientes. Hay dos grandes tipos de estudios estadísticos para estudiar causalidad: estudios experimentales y observacionales. En ambos tipos de estudios, el efecto de las diferencias de una variable independiente (o variables) en el comportamiento de una variable dependiente es observado. La diferencia entre los dos tipos es la forma en que el estudio es conducido. Cada uno de ellos puede ser muy efectivo.

Un estudio experimental implica tomar mediciones del sistema bajo estudio, manipular el sistema y luego tomar mediciones adicionales usando el mismo procedimiento para determinar si la manipulación ha modificado los valores de las mediciones. En contraste, un estudio observacional no necesita manipulación experimental. Por el contrario, los datos son recogidos y las correlaciones entre predictores y la respuesta son investigadas.

Un ejemplo de un estudio experimental es el famoso experimento de Hawthorne el cual pretendía probar cambios en el ambiente de trabajo en la planta Hawthorne de la Western Electric Company. Los investigadores estaban interesados en si al incrementar la iluminación en un ambiente de trabajo, la producción de los trabajadores aumentaba. Los investigadores primero midieron la productividad de la planta y luego modificaron la iluminación en un área de la planta para ver si cambios en la iluminación afectarían la productividad. La productividad mejoró bajo todas las condiciones experimentales. Sin embargo, el estudio fue muy criticado por errores en los procedimientos experimentales, específicamente la falta de un grupo control y seguimiento.

Un ejemplo de un estudio observacional es un estudio que explora la correlación entre fumar y el cáncer de pulmón. Este tipo de estudio normalmente usa una encuesta para recoger observaciones acerca del área de interés y luego produce un análisis estadístico. En este caso, los investigadores recogerían observaciones de fumadores y no fumadores y luego mirarían los casos de cáncer de pulmón en ambos grupos.

Los pasos básicos para un experimento son:

- Planeamiento estadístico de la investigación, lo cual incluye encontrar fuentes de información, selección de material disponible en el área y consideraciones éticas para la investigación y el método propuesto. Se plantea un problema de estudio,

- Diseñar el experimento concentrándose en el modelo y la interacción entre variables independientes y dependientes. Se realiza un muestreo consistente en la recolección de datos referentes al fenómeno o variable que deseamos estudiar. Se propone un modelo de probabilidad, cuyos parámetros se estiman mediante estadísticos a partir de los datos de muestreo. Sin embargo, se mantiene lo que se denominan «hipótesis sostenidas» (que no son sometidas a comprobación). Se valida el modelo comparándolo con lo que sucede en la realidad. Se utiliza métodos estadísticos conocidos como test de hipótesis o prueba de significación.

- Se producen estadísticas descriptivas.

- Inferencia estadística. Se llega a un consenso acerca de qué dicen las observaciones acerca del mundo que observamos.

- Se utiliza el modelo validado para tomar decisiones o predecir acontecimientos futuros. Se produce un reporte final con los resultados del estudio.

Niveles de medición

Hay cuatro tipos de mediciones o escalas de medición en estadística. Los cuatro tipos de niveles de medición (nominal, ordinal, intervalo y razón) tienen diferentes grados de uso en la investigación estadística. Las medidas de razón, en donde un valor cero y distancias entre diferentes mediciones son definidas, dan la mayor flexibilidad en métodos estadísticos que pueden ser usados para analizar los datos. Las medidas de intervalo tienen distancias interpretables entre mediciones, pero un valor cero sin significado (como las mediciones de coeficiente intelectual o temperatura en grados Celsius). Las medidas ordinales tienen imprecisas diferencias entre valores consecutivos, pero un orden interpretable para sus valores. Las medidas nominales no tienen ningún rango interpretable entre sus valores.

La escala de medida nominal, puede considerarse la escala de nivel más bajo. Se trata de agrupar objetos en clases. La escala ordinal, por su parte, recurre a la propiedad de «orden» de los números. La escala de intervalos iguales está caracterizada por una unidad de medida común y constante. Es importante destacar que el punto cero en las escalas de intervalos iguales es arbitrario, y no refleja en ningún momento ausencia de la magnitud que estamos midiendo. Esta escala, además de poseer las características de la escala ordinal, permite determinar la magnitud de los intervalos (distancia) entre todos los elementos de la escala. La escala de coeficientes o Razones es el nivel de medida más elevado y se diferencia de las escalas de intervalos iguales únicamente por poseer un punto cero propio como origen; es decir que el valor cero de esta escala significa ausencia de la magnitud que estamos midiendo. Si se observa una carencia total de propiedad, se dispone de una unidad de medida para el efecto. A iguales diferencias entre los números asignados corresponden iguales diferencias en el grado de atributo presente en el objeto de estudio.

Técnicas estadísticas

Algunos tests y procedimientos para investigación de observaciones bien conocidos son:

- Prueba t de Student

- Prueba de χ²

- Análisis de varianza (ANOVA)

- U de Mann-Whitney

- Análisis de regresión

- Correlación

- Iconografía de las correlaciones

- Prueba de la diferencia menos significante de Fisher

- Coeficiente de correlación producto momento de Pearson

- Coeficiente de correlación de rangos de Spearman

- Análisis factorial exploratorio

- Análisis factorial confirmatorio

Disciplinas especializadas

Algunos campos de investigación usan la estadística tan extensamente que tienen terminología especializada. Estas disciplinas incluyen:

- Ciencias actuariales

- Física estadística

- Estadística industrial

- Estadística Espacial

- Matemáticas Estadística

- Estadística en Medicina

- Estadística en Medicina Veterinaria y Zootecnia

- Estadística en Nutrición

- Estadística en Agronomía

- Estadística en Planificación

- Estadística en Investigación

- Estadística en Restauración de Obras

- Estadística en Literatura

- Estadística en Astronomía

- Estadística en la Antropología (Antropometría)

- Estadística en Historia

- Estadística militar

- Geoestadística

- Bioestadística

- Estadísticas de Negocios

- Estadística Computacional

- Estadística en las Ciencias de la Salud

- Investigación de Operaciones

- Estadísticas de Consultoría

- Estadística de la educación, la enseñanza, y la formación

- Estadística en la comercialización o mercadotecnia

- Cienciometría

- Estadística del Medio Ambiente

- Estadística en Epidemiología

- Minería de datos (aplica estadística y reconocimiento de patrones para el conocimiento de datos)

- Econometría (Estadística económica)

- Estadística en Ingeniería

- Geografía y Sistemas de información geográfica, más específicamente en Análisis espacial

- Demografía

- Estadística en psicología (Psicometría)

- Calidad y productividad

- Estadísticas sociales (para todas las ciencias sociales)

- Cultura estadística

- Encuestas por Muestreo

- Análisis de procesos y quimiometría (para análisis de datos en química analítica e ingeniería química)

- Confiabilidad estadística

- Procesamiento de imágenes

- Estadísticas Deportivas

La estadística es una herramienta básica en negocios y producción. Es usada para entender la variabilidad de sistemas de medición, control de procesos (como en control estadístico de procesos o SPC (CEP)), para compilar datos y para tomar decisiones. En estas aplicaciones es una herramienta clave, y probablemente la única herramienta disponible.

Computación estadística

El rápido y sostenido incremento en el poder de cálculo de la computación desde la segunda mitad del siglo XX ha tenido un sustancial impacto en la práctica de la ciencia estadística. Viejos modelos estadísticos fueron casi siempre de la clase de los modelos lineales. Ahora, complejos computadores junto con apropiados algoritmos numéricos, han causado un renacer del interés en modelos no lineales (especialmente redes neuronales y árboles de decisión) y la creación de nuevos tipos tales como modelos lineales generalizados y modelos multinivel.

El incremento en el poder computacional también ha llevado al crecimiento en popularidad de métodos intensivos computacionalmente basados en remuestreo, tales como tests de permutación y de bootstrap, mientras técnicas como el muestreo de Gibbs han hecho los métodos bayesianos más accesibles. La revolución en computadores tiene implicaciones en el futuro de la estadística, con un nuevo énfasis en estadísticas «experimentales» y «empíricas». Un gran número de paquetes estadísticos está ahora disponible para los investigadores. Los sistemas dinámicos y teoría del caos, desde hace una década, empezaron a interesar en la comunidad hispana, pues en la anglosajona de Estados Unidos estaba ya establecida la «conducta caótica en sistemas dinámicos no lineales» con 350 libros para 1997 y empezaban algunos trabajos en los campos de las ciencias sociales y en aplicaciones de la física. También se estaba contemplando su uso en analítica.

Críticas a la estadística

Hay una percepción general de que el conocimiento estadístico es intencionada y demasiado frecuentemente mal usado, encontrando maneras de interpretar los datos que sean favorables al presentador. Un dicho famoso, al parecer de Benjamin Disraeli,[2] es: «Hay tres tipos de mentiras: mentiras pequeñas, mentiras grandes y estadísticas». El popular libro How to lie with statisticsDarrell Huff discute muchos casos de mal uso de la estadística, con énfasis en gráficas malintencionadas. Al escoger (o rechazar o modificar) una cierta muestra, los resultados pueden ser manipulados; eliminando outliers por ejemplo. Este puede ser el resultado de fraudes o sesgos intencionales por parte del investigador. Lawrence Lowell (decano de la Universidad de Harvard) escribió en 1909 que las estadísticas, «como algunos pasteles, son buenas si se sabe quién las hizo y se está seguro de los ingredientes». (‘cómo mentir con las estadísticas’) de

Algunos estudios contradicen resultados obtenidos previamente, y la población comienza a dudar en la veracidad de tales estudios. Se podría leer que un estudio dice (por ejemplo) que «hacer X reduce la presión sanguínea», seguido por un estudio que dice que «hacer X no afecta la presión sanguínea», seguido por otro que dice que «hacer X incrementa la presión sanguínea». A menudo los estudios se hacen siguiendo diferentes metodologías, o estudios en muestras pequeñas que prometen resultados maravillosos que no son obtenibles en estudios de mayor tamaño. Sin embargo, muchos lectores no notan tales diferencias, y los medios de comunicación simplifican la información alrededor del estudio y la desconfianza del público comienza a crecer.

Sin embargo, las críticas más fuertes vienen del hecho que la aproximación de pruebas de hipótesis, ampliamente usada en muchos casos requeridos por ley o reglamentación, obligan una hipótesis a ser 'favorecida' (la hipótesis nula), y puede también exagerar la importancia de pequeñas diferencias en estudios grandes. Una diferencia que es altamente significativa puede ser de ninguna significancia práctica.

- Véase también críticas de prueba de hipótesis y controversia de la hipótesis nula.

En los campos de la psicología y la medicina, especialmente con respecto a la aprobación de nuevas drogas por la Food and Drug Administration, críticas de la aproximación de prueba de hipótesis se han incrementado en los años recientes. Una respuesta ha sido un gran énfasis en el p-valor en vez de simplemente reportar si la hipótesis fue rechazada al nivel de significancia α dado. De nuevo, sin embargo, esto resume la evidencia para un efecto pero no el tamaño del efecto. Una posibilidad es reportar intervalos de confianza, puesto que estos indican el tamaño del efecto y la incertidumbre. Esto ayuda a interpretar los resultados, como el intervalo de confianza para un α dado indicando simultáneamente la significancia estadística y el efecto de tamaño.

El p valor y los intervalos de confianza son basados en los mismos cálculos fundamentales como aquellos para las correspondientes pruebas de hipótesis. Los resultados son presentados en un formato más detallado, en lugar del si-o-no de las pruebas de hipótesis y con la misma metodología estadística.

Una muy diferente aproximación es el uso de métodos bayesianos. Esta aproximación ha sido, sin embargo, también criticada.

El fuerte deseo de ver buenas drogas aprobadas y el de ver drogas peligrosas o de poco uso siendo rechazadas crea tensiones y conflictos (errores tipo I y II en el lenguaje de pruebas de hipótesis).